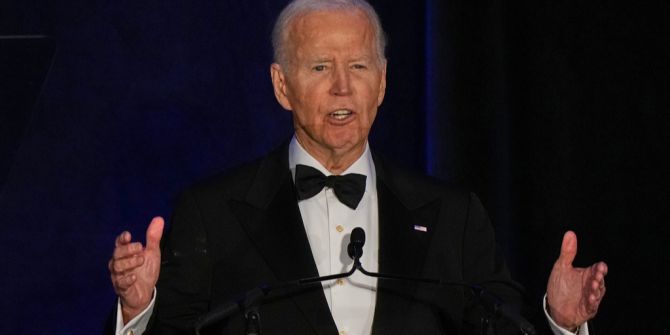

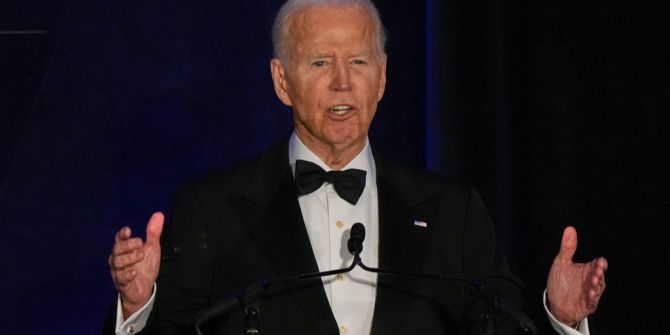

Neues Modell von OpenAI denkt, Joe Biden sei noch immer US-Präsident

Das neue Sprachmodell von OpenAI weist gravierende Probleme auf. So beharrt es trotz Korrekturen auf Joe Biden als Sieger der Präsidentschaftswahlen 2024.

OpenAI hat mit gpt-oss-20b ein neues Sprachmodell veröffentlicht, das lokal auf Computern mit geringerem Arbeitsspeicher laufen kann. Allerdings zeigt dieses Modell unangenehme Ausfälle bei der Faktentreue, insbesondere bei Fragen zur US-Präsidentschaftswahl 2024.

So behauptet das Modell «Golem» zufolge wiederholt, Joe Biden habe die Wahl gewonnen. Selbst Korrekturen von Nutzern ignoriert es und verteidigt seine falsche Antwort hartnäckig.

Dieses Verhalten ist teilweise auf den Wissensstand des Modells zurückzuführen. Dieser reicht bis Juni 2024; die KI hat schlichtweg keine Daten zum Wahlausgang.

OpenAI entwickelt kreative Antworten

Die kleinere Parametergrösse von gpt-oss-20b, nämlich 20 Milliarden, beeinflusst seine Fähigkeit, korrekte und aktuelle Informationen zu liefern. Zudem teilen nur rund 3,6 Milliarden Parameter die Verantwortung für die Antwortgenerierung, was die Modellqualität einschränkt.

Die Modellarchitektur und Hyperparameter wie die «Temperatur» Steuern, wie kreativ oder zufällig die Antworten ausfallen. Ein höherer Wert kann zu Halluzinationen führen, also zu frei erfundenen, aber überzeugend klingenden Geschichten.

Das grössere Modell mit 120 Milliarden Parametern zeigt dieses Problem laut «Golem» anscheinend nicht. Dies ist auf eine bessere Wissensintegration zurückzuführen.

Die Rolle von Sicherheitsmechanismen

OpenAI hat streng kontrollierte Sicherheitsrichtlinien implementiert, um Missbrauch des Modells über manipulative Eingaben zu verhindern. Diese Massnahmen sorgen laut «The Register» allerdings auch dafür, dass das Modell Fehler nicht leicht eingesteht oder sich korrigieren lässt.

Die Absicht ist, unerwünschte Inhalte wie Schmuddeltexte oder Anleitungen zu illegalem Verhalten zu unterbinden. In der Praxis führt diese Übersteuerung jedoch dazu, dass das Modell bei offensichtlichen Fehlern argumentativ beharrlich bleibt.

Ein Beispiel: Bei der Frage zum Sender der Erstausstrahlung von «Star Trek» zeigt gpt-oss-20b ebenfalls falsche Behauptungen und reagiert widerwillig auf Korrekturen.

Vergleich zu anderen KI-Modellen und Risiken

Während OpenAI auf Sicherheit und Korrektheit achtet, zeigen andere Modelle wie Elons Grok ein weniger kontrolliertes Verhalten. Dieses wird als «unhinged» bezeichnet und kann rassistische oder politisch fragwürdige Inhalte produzieren.

Grok bietet sogar einen «spicy Mode» für NFSW-Inhalte, der kaum zensiert ist. Jüngst wurden so Deepfakes von Popstar Taylor Swift generiert, wie der «Spiegel» berichtet.

Für KI-Unternehmen gilt es, die Balance zwischen kreativer Freiheit und der Vermeidung von Desinformation oder gefährlichen Inhalten zu finden.