DeepMind: KI «AlphaTensor» entdeckt neuen mathematischen Algorithmus

«AlphaTensor» von DeepMind ist ein mathematischer Durchbruch gelungen. Ein neuer Algorithmus ermöglicht eine höhere Effizienz bei der Matrizenmultiplikation.

Das Wichtigste in Kürze

- «AlphaTensor» ist eine KI von Googles Tochterfirma DeepMind.

- Sie hat einen neuen, mathematischen Algorithmus entdeckt.

- Damit soll es möglich sein, Matrizen bis zu 20 Prozent schneller zu multiplizieren.

Googles Tochterunternehmen DeepMind ist im Bereich der Mathematik ein neuer Durchbruch gelungen. Die KI «AlphaTensor» hat einen Weg gefunden, Matrizen bis zu 20 Prozent effizienter zu multiplizieren.

Matrizenmultiplikation ist essenziell für die digitale Signalverarbeitung – und somit auch enorm wichtig für die meisten Computer: Grafische Darstellung, digitale Kommunikation und wissenschaftliche Nutzung sind davon abhängig. Seit 1969 galt der Algorithmus des deutschen Mathematikers Volker Strassen als die effizienteste Methode, um zwei Matrizen zu multiplizieren.

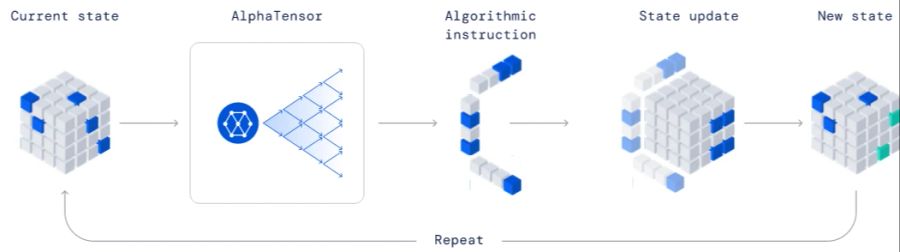

Forscher bei DeepMind haben die KI «AlphaTensor» entwickelt, um in diesem Bereich der Mathematik neue Methoden zu entdecken. Sie ist Nachfolger von «AlphaGo» und «AlphaZero», welche bereits mit ihrem Können bei Brettspielen wie Go und Schach Schlagzeilen machten.

Die Forscher gingen bei AlphaTensor mit einer ähnlichen Methode vor: Sie liessen die KI ein «Spiel» spielen, dessen Ziel es ist, einen neuen Weg zur Matrizenmultiplikation zu finden. Wurde ein korrekter Algorithmus gefunden, wurde er auf spezifischer Hardware auf seine Effizienz getestet.

Gesucht, gefunden: Um eine 4x5-Matrix mit einer 5x5-Matrix zu multiplizieren, braucht man auf dem herkömmlichen Weg 100 Rechenoperationen. Strassens Algorithmus hat diese Zahl auf 80 Multiplikationen heruntergebrochen. Mit der neuen Methodik von AlphaTensor braucht man nur noch 76 Operationen.

Zunächst klingt das nach einer bescheidenen Verbesserung. Dennoch sind die Implikationen gross. Auf der getesteten Hardware wurde laut den Entwicklern das gesuchte Ergebnis um 10 bis 20 Prozent schneller erreicht. Würde ein Supercomputer jeweils 10 bis 20 Prozent schneller arbeiten, könnte damit einiges an Zeit und Energie gespart werden.