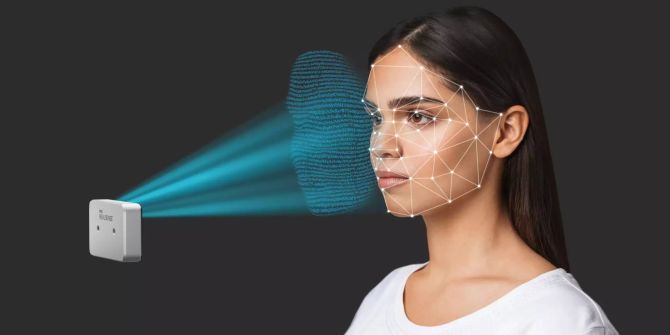

«FakeCatcher»: Intel will Deepfakes mittels Blut entlarven

DeepFakes, also gefälschte Videos von Personen, könnten bald zur ernsten Gefahr werden. Intel will dem entgegenwirken – per Erkennung vom Blutkreislauf.

Das Wichtigste in Kürze

- Im Netz kursieren zunehmend viele täuschend echte DeepFake-Videos von Personen.

- Diese gefälschten Clips will Intel bald mit einem neuen "FakeCatcher" entlarven.

- Das Tool soll in der Lage sein, im Video die Venen von echten Personen zu erkennen.

Aus dem Hause Intel wurde neulich eine ganz neue Art zur Erkennung von DeepFakes präsentiert. Bei diesen DeepFakes handelt es sich um digital generierte Videos, oft von Celebrities oder politischen Persönlichkeiten. Damit wir nicht von solchen Videos getäuscht werden, wurde nun ein «FakeCatcher» entwickelt. Dieser kann die Echtheit von Videos per Blut-Erkennung feststellen.

Wie erkennt Intel die DeepFakes?

Das Prinzip ist im Grunde genommen recht simpel: Das Blut, welches durch den menschlichen Körper fliesst, sorgt kontinuierlich für minimalste Farb-Veränderungen unserer Haut. Dies ist bei künstlich generierten Videos in der Regel nicht der Fall.

Diese farblichen Änderungen sind von Auge praktisch unmöglich wahrzunehmen. Der «FakeCatcher» von Intel soll jedoch in der Lage sein, dies zu registrieren. Auch die Blickrichtung der Augen wird analysiert, da diese besonders schwer zu fälschen ist. Zudem funktioniert das Ganze sogar in Echtzeit.