Sek-Schüler teilen KI-Nacktbilder von Mitschülerinnen

Mit KI lassen sich innert Sekunden täuschend echte Nacktbilder erstellen. Auch an einer Schweizer Schule wurden solche Deepfakes über Snapchat verbreitet.

Das Wichtigste in Kürze

- In einer Deutschschweizer Sekundarschule ist es zu einem Deepfake-Eklat gekommen.

- Mithilfe von KI haben Sekundarschüler Nacktbilder ihrer Mitschülerinnen erstellt.

- Anschliessend wurden die Fake-Bilder über Snapchat weiterverbreitet.

Künstliche Intelligenz (KI) ist längst Teil des Alltags. Wer regelmässig mit ChatGPT & Co. arbeitet, bewegt sich scheinbar selbstverständlich in der Welt digitaler Bots und Programme.

Doch die Gefahren lauern. Besonders alarmierend ist die Zunahme von KI-generierten, sexualisierten Bildern – sogenannten Deepfakes. Immer häufiger sind davon auch Kinder und Jugendliche betroffen.

Deepfakes bezeichnen Bilder, Videos oder Audiodateien, die mithilfe künstlicher Intelligenz erzeugt oder manipuliert werden. Sie wirken täuschend echt – und werden zunehmend missbraucht, um Menschen digital zu entkleiden und erfundene Nacktdarstellungen zu erstellen.

Ein Fall im vergangenen Jahr führt zu einer Deutschschweizer Schule, wie der «Tagesanzeiger» schreibt.

Sek-Schüler teilten KI-Nacktbilder auf Snapchat

Der genaue Standort der Schule wird nicht genannt. Jugendliche sollen mithilfe von KI sexualisierte Bilder von Mitschülerinnen erstellt haben.

Gegen die Beteiligten läuft mittlerweile ein Verfahren bei der kantonalen Jugendanwaltschaft. Nach der Erstellung sollen die Jugendlichen die manipulierten Bilder über Snapchat weiterverbreitet haben – ohne Einwilligung der betroffenen Mädchen.

Dass dies strafrechtliche Konsequenzen haben kann, bestätigt Martin Wyss gegenüber der Zeitung.

Der Rechtsanwalt und wissenschaftliche Mitarbeiter der Universität Zürich erklärt: Handle es sich um Minderjährige, «kann dies unter das Verbot der Herstellung und Verbreitung von Kinderpornografie fallen».

«Viel Spass beim gratis Ausziehen!»

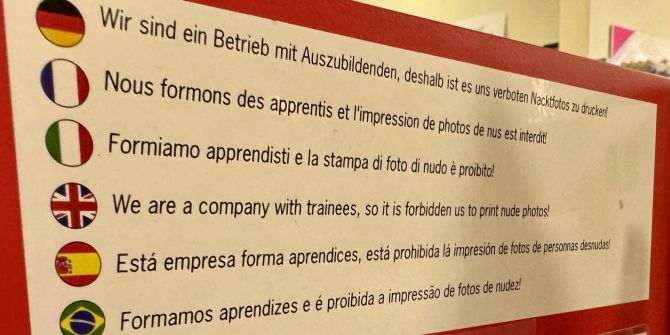

Erstellt wurden die Bilder laut Bericht über eine frei zugängliche Webseite. Eine Alterskontrolle gibt es dort offenbar nicht. Weder eine Registrierung noch die Hinterlegung von Zahlungsdaten ist erforderlich.

Die Plattform wirbt offen damit, jede beliebige Person «in nur ein paar Sekunden» ausziehen zu können. Technische Vorkenntnisse seien nicht nötig, körperliche Merkmale – auch intime – liessen sich nach Belieben verändern.

Hinter dem Angebot soll ein 44-jähriger Mann aus Shenzhen in China stehen. Er verspricht «hyperrealistische» Ergebnisse. Sogar Gesichter aus Fotos können demnach in pornografische Videos integriert werden.

Im Fokus stehen dabei vor allem junge Frauen. Mit Slogans wie «Neugierig auf ihren Körper? Viel Spass beim gratis Ausziehen!» wird gezielt zum Missbrauch der Technik animiert.

Phänomen ist weltweit bekannt

Dass es sich nicht um Einzelfälle handelt, zeigt eine Studie von Unicef, Expat und Interpol. Demnach gaben mindestens 1,2 Millionen Kinder aus elf Ländern an, bereits mit sexualisierten Deepfakes konfrontiert worden zu sein.

Viele Jugendliche sind sich der Risiken bewusst, die mit dem Einsatz von KI einhergehen. Dennoch wächst die Sorge über die zunehmende Verbreitung solcher Inhalte über Ländergrenzen hinweg.

Unicef pocht deshalb umso mehr darauf, den Bedarf an Sensibilisierung und wirksamen Präventions- und Schutzmassnahmen zu verstärken.