Gefahr? Angestellte sollen mit KI über psychische Belastung reden

Künstliche Intelligenz begleitet uns heutzutage in vielen Bereichen. Die technisch generierte «Ella» soll nun bei psychischen Problemen am Arbeitsplatz helfen.

Das Wichtigste in Kürze

- Immer mehr Menschen lassen sich in verschiedensten Situationen von KI helfen.

- Avatar «Ella» soll nun bei psychischen Herausforderungen am Arbeitsplatz nützen.

- Zwei Experten ordnen die technische Anwendung ein.

Die Künstliche Intelligenz (KI) ist heutzutage allgegenwärtig. In verschiedensten Situationen lassen wir uns von der Technologie helfen. Auch in Stresssituationen wenden sich immer mehr an Chatbots wie beispielsweise ChatGPT.

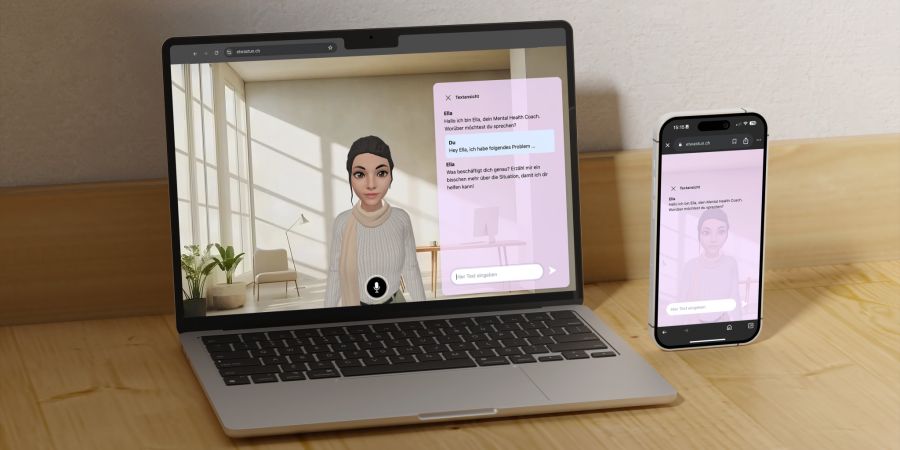

Nun soll es eine neue, innovative Lösung geben. Die Webanwendung «Etwastun?!», ein Projekt vom Angestelltenverband Angestellte Schweiz und dem Gesundheitszentrum WorkMed, hat eine neue digitale Begleiterin namens «Ella» entwickelt.

Künstliche Intelligenz als Hilfe

Ella hilft den Nutzerinnen und Nutzern, über ihre mentalen Herausforderungen am Arbeitsplatz zu sprechen und gemeinsam Lösungen zu finden.

In einer Medienmitteilung schreibt Angestellte Schweiz: «Psychische Belastung am Arbeitsplatz wird oft als persönliche Schwäche wahrgenommen – Hilfe zu suchen fällt daher nicht leicht. So ist der Rückgriff auf Ella spontan, von überall aus und ohne finanziellen Aufwand möglich.»

Ein technisch generierter Avatar soll Mitarbeitenden also bei psychischen Problemen helfen. Wie gefährlich ist das?

Nau.ch hat bei Experten nachgefragt, wie sie diese Technologie einschätzen.

Wirksamkeit muss noch überprüft werden

«Zahlreiche Studien belegen inzwischen die Wirksamkeit digitaler Interventionen», meint Thomas Berger. Er ist Leiter der Abteilung klinische Psychologie und Psychotherapie an der Uni Bern und forscht in Online-Psychotherapie.

Er fügt aber hinzu: «Für Chatbots und avatarbasierte Anwendungen, wie Ella eine ist, liegt bislang nur eine begrenzte Studienlage vor.»

Entsprechende Interventionen gebe es noch nicht so lange. Daher müsse ihre Wirksamkeit noch systematisch überprüft werden.

Der Professor warnt aber: «Nach aktuellem Erkenntnisstand reicht das blosse Schreiben oder Sprechen mit einem Chatbot nicht aus, um positive Effekte zu erzielen.»

Und: «Aus der vorliegenden Beschreibung der Anwendung geht für mich nicht hervor, welche etablierten psychologischen Wirkmechanismen gezielt aktiviert werden sollen.» Die Untersuchung der Wirkung sei ein wichtiger nächster Schritt, so Berger.

«Gute Möglichkeit, um über Probleme zu sprechen»

KI-Experte Mike Schwede sieht Ella grundsätzlich als eine gute Möglichkeit, um über Probleme zu sprechen. So habe man eine anonyme Quelle, mit der man über heikle Themen reden und gewisse Lösungen finden könne.

Daher sei es sicher ein sehr guter Ansatz, wenn die Qualität der Antworten dann auch stimme. «Dies wird sich über die Zeit dann zeigen», sagt Schwede. Ein Monitoring und kontinuierliches Nachtrainieren seien hier wichtig.

Der Experte für Künstliche Intelligenz kritisiert aber die Vermenschlichung der Technologie: «Bei solchen Anwendungen ist wichtig, dass man keine persönliche Beziehung zum Chatbot aufbaut.»

Denn: «Sobald man mit Bild und Stimme arbeitet, ist diese Wahrscheinlichkeit höher.» Durch einen Textchat würde das Ganze anonymer wirken.

Als Beispiel nennt er den Voice Chat von ChatGPT. «Die anonyme Stimme ist klar virtuell und wird nicht durch ein Bild vermenschlicht.»

Technische Umsetzung etwas holprig

Auch die technische Umsetzung beurteilt Schwede als noch etwas holprig. «Es fehlen die Verlinkungen auf Quellen», sagt er. Zudem müsse man den Bot stark forcieren, damit Ella Antworten gebe und nicht noch mehr Fragen stelle.

Die Künstliche Intelligenz bringe aber auch Gefahren mit sich. Schwede sieht da die typischen Risiken: falsche Informationen, nicht genügende Informationen und Halluzinationen.

Thomas Berger sieht neben Datenschutzbedenken auch die Gefahr unangemessener, potenziell schädlicher oder unzureichender Reaktionen der KI-Systeme. «Insbesondere in psychischen Krisensituationen», wie Berger sagt.