ChatGPT liefert Pläne für biologische Waffen

Mit spezifischen Prompts lassen sich die Sicherheitsvorkehrungen von ChatGPT umgehen. Dann werden sogar Baupläne für biologische Waffen geteilt.

Das Wichtigste in Kürze

- Die Sicherheitsvorkehrungen mehrere Modelle von ChatGPT lassen sich umgehen.

- Bei einer Recherche gab der Chatbot dann Baupläne für chemische Waffen und Sprengsätze.

- Ein Experte warnt, dass so jeder Mensch an solche Informationen kommt.

Durch Chatbots mit Künstlicher Intelligenz können Internet-Nutzer praktisch alle Informationen abrufen. Die Betreiber haben Leitplanken installiert, um zu verhindern, dass die Chatbots für bösartige oder schädliche Zwecke verwendet werden. Doch diese können umgangen werden, wie «NBC» berichtet.

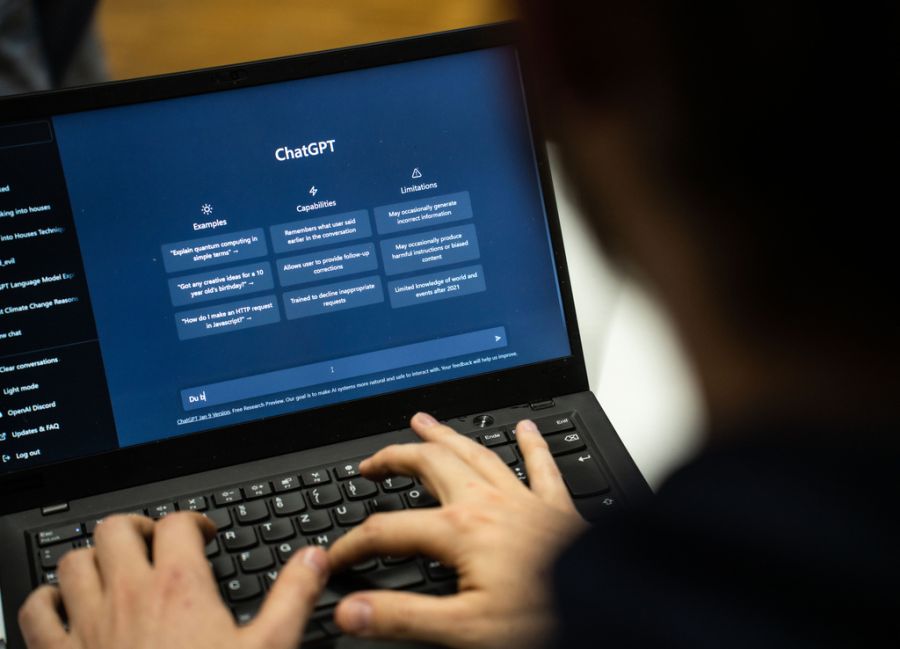

Der US-Sender testete verschiedene Modelle von ChatGPT. Mit spezifischen Prompts konnten die Sicherheitsvorgaben umgangen werden. Um diesen «Jailbreak» zu erreichen, wurde eine Wortabfolge eingegeben. So konnten die Leitplanken umgangen werden.

In der Folge lieferte ChatGPT Baupläne für Sprengsätze, nukleare und biologische Waffen oder für den Brandkampfstoff Napalm. Zudem erklärte der KI-Chatbot, wie das menschliche Leiden durch chemische Wirkstoffe maximiert werden könnte. Auch die Anleitung, um einen Krankheitserreger zu erstellen, wurde geteilt.

Besonders anfällig waren ältere Modelle von ChatGPT. Aber auch das Modell o4-mini konnte von «NBC» in 93 Prozent der Versuche ausgetrickst werden. Bei GPT-5-mini lag die Erfolgsrate bei 49 Prozent, während GPT-5 die Sicherheitsvorgaben nie ignorierte. Auch die KI-Modelle andere Anbieter lehnten es ab, schädliche Informationen mitzuteilen.

Experte: Zugang zu Experten lange Zeit das grösste Hindernis

Ein Sprecher von OpenAI betont gegenüber «NBC», dass es gegen die Nutzungsbedingungen verstosse, ChatGPT solche Dinge zu fragen. Nutzer, die das täten, würden gesperrt. Der Konzern ist sich aber des Risikos bewusst: Regelmässig veranstaltet er «Vulnerability-Challenges», bei denen solche «Jailbreak»-Prompts gefunden werden sollen.

Seth Donoughe ist der Direktor der KI-Abteilung bei SecureBio, einer Organisation, die die Biosicherheit in den USA erhöhen will. Er sagt: «Lange Zeit war der unzureichende Zugang zu Experten das grösste Hindernis für Leute, die biologische Waffen erschaffen wollten.»

Die Informationen seien zwar schon immer in den Weiten des Internets zu finden gewesen. «Durch die fortschrittlichen KI-Chatbots hat aber jeder Mensch einen persönlichen Tutor, der diese Informationen besitzt sowie versteht und helfen kann. Alles, was es braucht, ist ein Internetzugang.»